110 millions de dollars pour une plateforme d’IA générative

d-Matrix, leader dans le domaine de l’informatique générative à haute efficacité pour les centres de données, a conclu un financement de série B de $110 millions, mené par la société d’investissement mondiale Temasek, basée à Singapour.

L’objectif de cette levée de fonds est de permettre à d-Matrix de commencer à commercialiser Corsair, la première plateforme de calcul d’inférence d’IA basée sur les chiplets DIMC (Digital-In Memory Compute), après les lancements réussis de ses chiplets Nighthawk, Jayhawk-I et Jayhawk II.

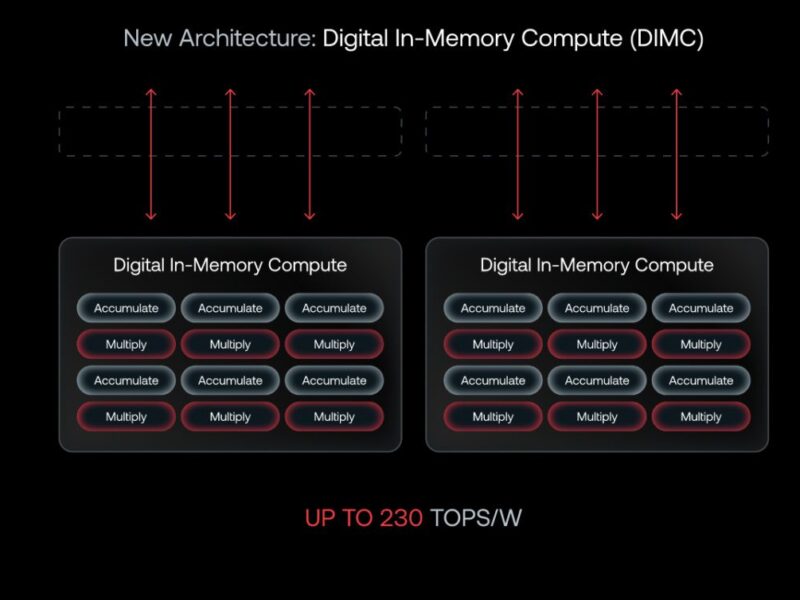

La récente annonce de d-Matrix, Jayhawk II, est le dernier exemple en date de la manière dont l’entreprise s’efforce de modifier fondamentalement la physique des charges de travail de calcul liées à la mémoire, qui sont courantes dans les applications d’IA générative et de grands modèles de langage (LLM). Avec l’explosion de cette technologie révolutionnaire au cours des neuf derniers mois, il n’a jamais été aussi nécessaire de surmonter le goulot d’étranglement de la mémoire et les approches technologiques actuelles qui limitent les performances et augmentent les coûts de calcul de l’IA. d-Matrix a conçu un moteur DIMC élégant et une solution basée sur les chiplets pour permettre l’inférence à un coût total de possession (TCO) inférieur à celui des alternatives basées sur le GPU. Cette nouvelle plateforme DIMC basée sur les chiplets, qui sera commercialisée en 2024, redéfinira la catégorie, positionnant d-Matrix comme le chef de file de l’inférence efficace en matière d’IA.

« La trajectoire actuelle du calcul de l’IA n’est pas viable, car le coût total de possession pour exécuter l’inférence de l’IA augmente rapidement », a déclaré Sid Sheth, cofondateur et PDG de d-Matrix. « L’équipe de d-Matrix est en train de changer les coûts économiques du déploiement de l’inférence IA avec une plateforme de calcul conçue spécialement pour les LLM, et ce tour de financement valide notre position dans l’industrie ».

« d-Matrix est l’entreprise qui rendra l’IA générative commercialement viable », a déclaré Sasha Ostojic, partenaire de Playground Global. « Pour atteindre cet objectif ambitieux, d-Matrix a produit une architecture de flux de données innovante, assemblée en chiplets, connectée par une interface à grande vitesse et pilotée par une pile logicielle évolutive de classe entreprise. Playground ne pouvait pas être plus enthousiaste et fier de soutenir Sid et l’équipe d-Matrix alors qu’elle répond à la demande de clients enthousiastes qui ont désespérément besoin d’une économie améliorée. »

« Nous entrons dans la phase de production où le coût total de possession de l’inférence LLM devient un facteur essentiel pour déterminer dans quelle mesure, où et quand les entreprises utilisent l’IA avancée dans leurs services et applications », a déclaré Michael Stewart de M12, le fonds de capital-risque de Microsoft. « d-Matrix a suivi un plan qui lui permettra d’atteindre le meilleur coût total de possession du secteur pour une variété de scénarios de services modèles potentiels en utilisant une architecture de chiplets flexible et résiliente basée sur une approche centrée sur la mémoire ».

d-Matrix a été fondée en 2019 pour résoudre le problème de l’intégration mémoire-calcul, qui constitue la dernière frontière de l’efficacité de calcul de l’IA. d-Matrix a investi dans des technologies révolutionnaires de chiplet et de calcul numérique en mémoire dans le but de mettre sur le marché une solution d’inférence performante et rentable en 2024. Depuis sa création, d-Matrix a connu une croissance substantielle en termes d’effectifs et d’espace de bureau. Son siège social se trouve à Santa Clara, en Californie, et elle possède des bureaux à Bengaluru, en Inde, et à Sydney, en Australie. Avec ce financement de série B, d-Matrix prévoit d’investir dans le recrutement et la commercialisation de son produit afin de répondre aux besoins immédiats des clients en matière d’infrastructure de calcul moins coûteuse et plus efficace pour l’inférence générative de l’IA.

Si vous avez apprécié cet article, vous aimerez les suivants : ne les manquez pas en vous abonnant à :

ECI sur Google News

Si vous avez apprécié cet article, vous aimerez les suivants : ne les manquez pas en vous abonnant à :

ECI sur Google News