Tachyum divise par 100 les coûts des LLM pour les généraliser

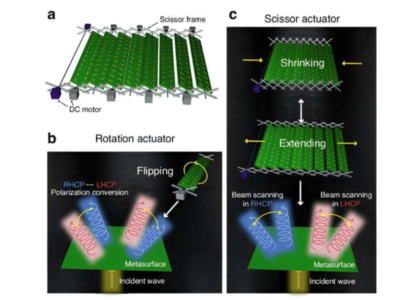

Tachyum® a détaillé dans un livre blanc comment utiliser les formats 4-bit Tachyum AI (TAI) et 2-bit effective per weight (TAI2) dans la quantification des Large Language Models (LLMs) sans dégradation de la précision.

Le matériel Tachyum permet également de réaliser des LLM à 1 bit par poids avec une dégradation plus importante que TAI2 et ses chercheurs en IA continuent d’améliorer les performances afin de réduire la dégradation, alors que Tachyum cherche à généraliser son utilisation.

Tachyum s’adresse aux modèles LLM massifs dont les capacités ont été multipliées par plus de mille au cours des dernières années. Parmi les exemples de ces augmentations, citons ChatGPT-3.5 LLM avec 175 milliards de paramètres, PALM LLM avec 530 milliards de paramètres denses et Switch Transformer avec 1,6 trillion de paramètres épars.

Par exemple, un Switch Transformer de 1,6 trillion de paramètres nécessiterait 52 GPU NVIDIA H100 de 80 Go à 41 789 dollars chacun, plus 7 serveurs GPU Supermicro de 25 000 dollars, soit un total de 2 348 028 dollars. En revanche, un système Prodigy à socket unique de 23 000 dollars avec 2 To de DRAM DDR5 pourrait prendre en charge et faire tourner de tels modèles de grande taille et les faire entrer dans le domaine courant des applications d’IA générative.

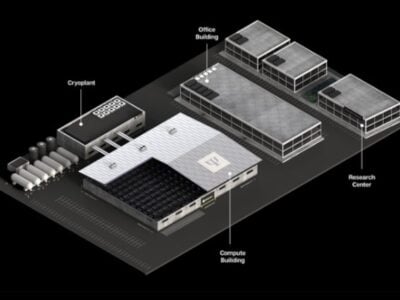

Les systèmes d’IA construits sur des puces universelles Prodigy avec 256PB DDR5 DRAM (Dynamic Access Random Memory) utilisant les formats de données FP8 (8-bit floating point) et 4-bit Tachyum AI (TAI) peuvent prendre en charge des modèles ayant jusqu’à 100 quadrillions de paramètres. Il peut soutenir plus de 150 000 modèles ChatGPT ou 610 000 modèles PALM2 et offre d’énormes possibilités d’utilisation des LLM en tant que technologie courante dans divers secteurs, tels que la vente au détail et le commerce électronique, le marketing, la finance, la cybersécurité, l’armée et les soins de santé, y compris la mise au point plus rapide de médicaments ou la mise en œuvre pratique de la médecine personnalisée dans les hôpitaux.

Le déploiement efficace des LLM nécessite une quantification à faible-bit pour minimiser la taille du modèle et le coût de l’inférence. Les formats entiers à faible-bit, tels que INT8 et INT4, ont été le choix conventionnel, mais les nouveaux formats exponentiels à faible bit offrent une alternative convaincante. À des coûts raisonnables, les LLM pourraient être déployés par des entreprises de toutes tailles dans divers secteurs d’activité. Les LLM pourraient faire partie intégrante de la présence d’une organisation sur le web afin d’offrir une expérience interactive, par exemple en permettant aux visiteurs de poser des questions de manière naturelle plutôt que d’entrer des termes de recherche.

« En combinant des poids TAI 4 bits et les poids efficaces 2 bits avec FP8 par activation, nous sommes capables de quantifier les LLM sans trop de dégradation de la précision », a déclaré le Dr Radoslav Danilak, fondateur et PDG de Tachyum. « Nos techniques évitent les multiplications coûteuses tout en réduisant la taille du modèle de 4 à 8 fois, ce qui permet d’obtenir des modèles d’IA génératifs qui peuvent être appliqués à des cas d’utilisation allant des tâches complexes de modélisation du langage, à la génération de textes, à la conception de médicaments et de puces, à l’apprentissage et au raisonnement à court terme et à la modélisation de séquences de protéines. Tachyum AI ouvre de toutes nouvelles voies de calcul ».

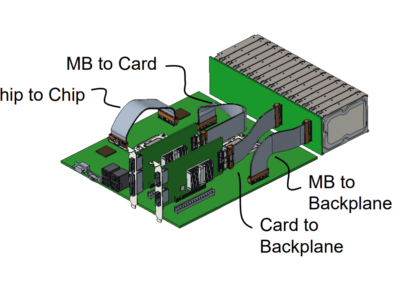

En tant que processeur universel offrant des performances de pointe pour toutes les charges de travail, les serveurs de centre de données alimentés par Prodigy peuvent basculer de manière transparente et dynamique entre les domaines de calcul (tels que l’IA/ML, le HPC et le cloud) avec une seule architecture homogène. En éliminant le besoin de matériel d’IA dédié coûteux et en augmentant considérablement l’utilisation des serveurs, Prodigy réduit considérablement les dépenses d’investissement et les dépenses d’exploitation tout en offrant des performances, une puissance et des économies sans précédent dans les centres de données. Prodigy intègre 192 cœurs de calcul 64 bits haute performance conçus sur mesure, pour offrir jusqu’à 4,5 fois les performances des processeurs x86 les plus performants pour les charges de travail en cloud, jusqu’à 3 fois celles du GPU le plus performant pour le HPC, et 6 fois pour les applications d’IA.

L’article : « Mainstreaming Large Language Models With 2-bit TAI Weights » est disponible ici.

Si vous avez apprécié cet article, vous aimerez les suivants : ne les manquez pas en vous abonnant à :

ECI sur Google News

Si vous avez apprécié cet article, vous aimerez les suivants : ne les manquez pas en vous abonnant à :

ECI sur Google News